![[レポート]Amazon SageMaker MLOps & FMOpsを使用してGen AIの生産性を加速 #AWSReInvent #AIM354](https://images.ctfassets.net/ct0aopd36mqt/3IQLlbdUkRvu7Q2LupRW2o/edff8982184ea7cc2d5efa2ddd2915f5/reinvent-2024-sessionreport-jp.jpg?w=3840&fm=webp)

[レポート]Amazon SageMaker MLOps & FMOpsを使用してGen AIの生産性を加速 #AWSReInvent #AIM354

この記事は公開されてから1年以上経過しています。情報が古い可能性がありますので、ご注意ください。

こんにちは、せーのです。

AWS Re:Invent2024、今回はAIM354「Accelerate production for gen AI using Amazon SageMaker MLOps & FMOps」のレポートをお送りします。

セッション概要

Amazon SageMakerは、機械学習と生成AIのワークフローの両方において、信頼性の高い本番環境へのパスを作成するための専用ツールを提供します。SageMaker MLOpsは、生成AIとMLのライフサイクル全体にわたるプロセスの自動化と標準化を支援します。SageMakerを使用すると、トレーニング、テスト、トラブルシューティング、デプロイ、およびモデルの管理を大規模に行うことができ、生産性を向上させながら本番環境でのモデルのパフォーマンスを維持することができます。MLflow を使用した SageMaker Experiments、SageMaker Pipelines、SageMaker Model Registry など、ML ワークフロー(MLOps)と生成的 AI ワークフロー(FMOps)の効率化をサポートする最新かつ最高の機能を探求しましょう。生成的 AI のコンセプトを迅速かつ安全に実運用に移す方法をご覧ください。

3行まとめ

- SageMaker MLOpsの3つの主要機能(実験管理、モデル管理、パイプライン)を活用することで、生成AIモデルの本番環境への展開を効率化できる

- GenAI特有の課題(プロンプトエンジニアリング、モデル選定、出力品質管理など)に対応したツールセットを提供

- 実証済みのワークフローとベストプラクティスに従うことで、信頼性の高い生成AIシステムの構築が可能

セッション内容

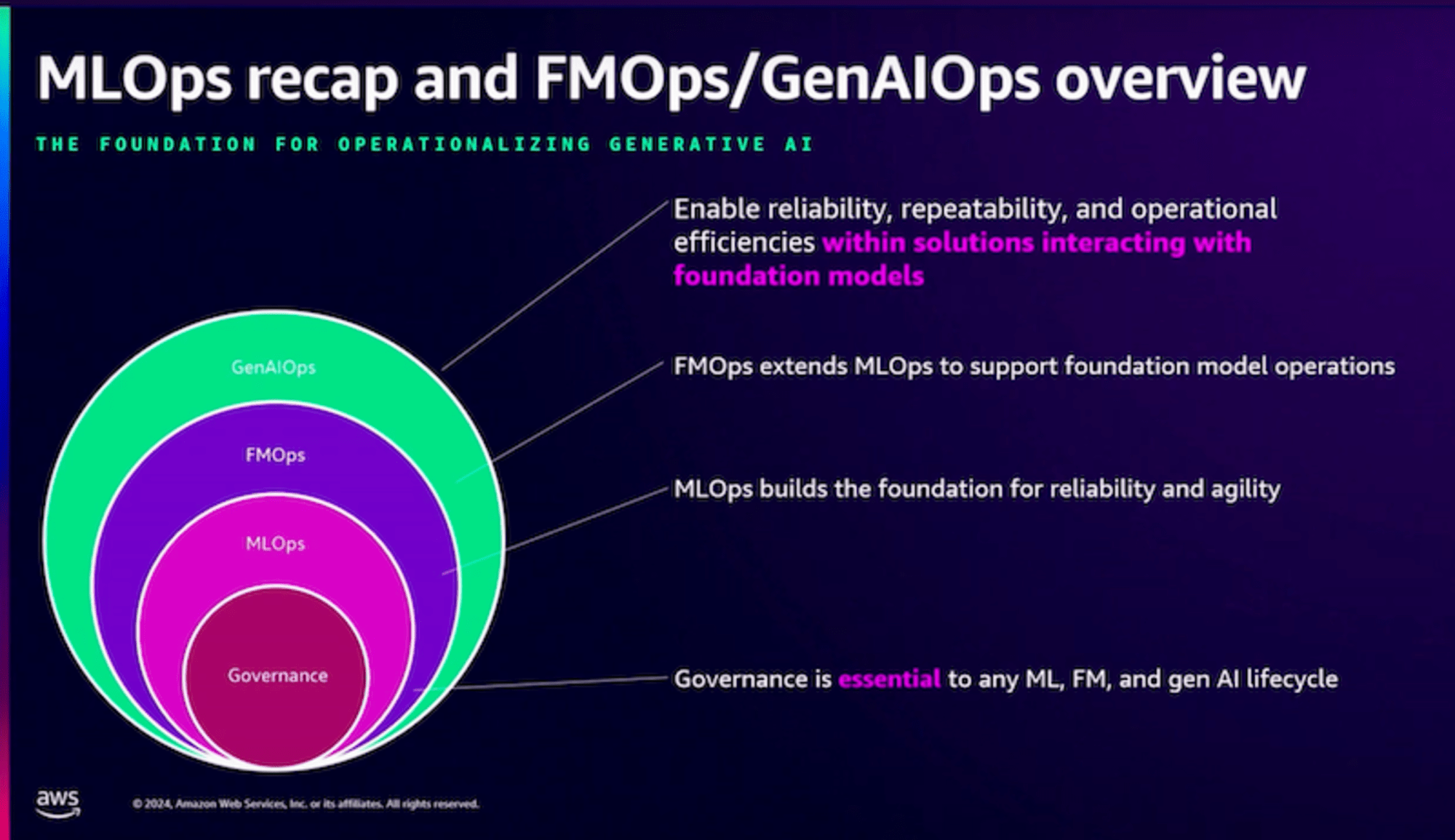

MLOps/FMOps/GenOpsの概念整理

セッションではまず、MLOps、FMOps、GenOpsという3つの概念の関係性について説明がありました。MLOpsは機械学習モデルの開発・デプロイ・運用の自動化基盤として、すでに多くの企業で活用されています。一方、Foundation Model特有の課題に対応するFMOpsは比較的新しい分野ですが、MLOpsの知見が活かせる部分が多いのが特徴です。

各Opsの特徴を比較すると以下のようになります:

| 項目 | 主な特徴 | 重要な要素 | 目的 |

|---|---|---|---|

| MLOps | 機械学習モデルの開発・運用の基盤 | 実験管理、モデル管理、パイプライン | 信頼性と俊敏性の確保 |

| FMOps | Foundation Model向けの運用拡張 | プロンプト管理、モデル選定、出力品質管理 | Foundation Modelの効率的な活用 |

| GenOps | 生成AI全体のソリューション | エージェント開発、RAG、アプリケーション統合 | 生成AIソリューションの信頼性と運用効率の向上 |

プロンプト管理の重要性

プロンプト管理については、テンプレート化とバージョン管理、評価結果との紐付け、チーム間での再利用性向上が重要です。従来のMLOpsにはなかった新しい課題ですが、SageMakerは既存のバージョン管理の仕組みを拡張することで対応しています。

MLflow Integrationによる実験管理

Managed MLflowの提供開始により、運用負荷を大幅に削減できます。SageMaker Model Registryとの自動同期により、モデルのライフサイクル管理がよりスムーズになりました。

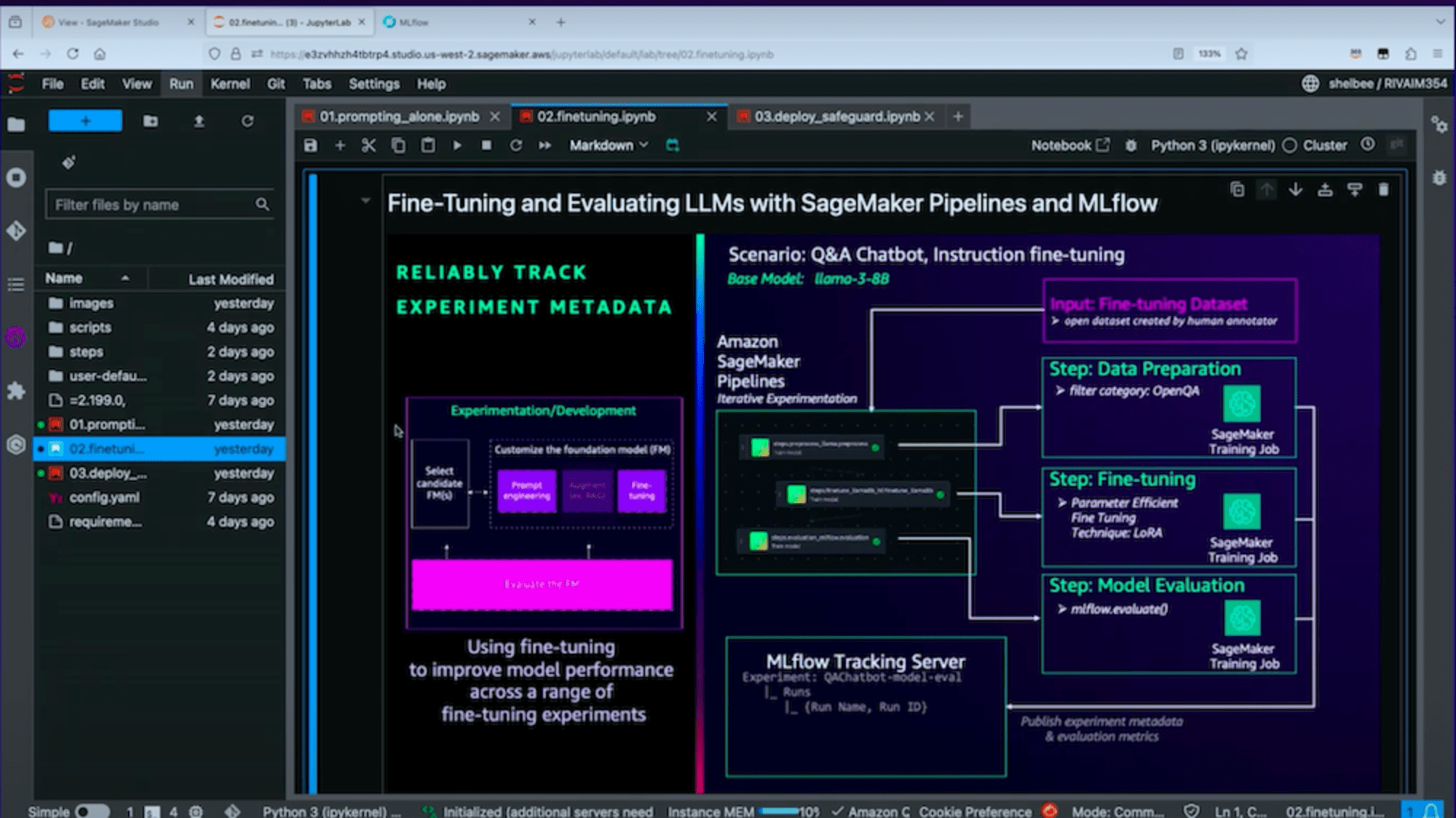

パイプラインによる自動化とHuman-in-the-loop

パイプラインの自動化は、実用的な生成AIシステムを構築する上で必須の機能です。SageMakerは、Foundation Modelのファインチューニングにおいて、以下のような体系的なパイプラインを提供しています。

画像のように、データ準備からモデル評価まで、一連のプロセスを自動化できます。具体的には:

- データ準備:人間のアノテーターによって作成されたデータセットを使用

- ファインチューニング:LoRAなどのパラメータ効率の良い手法を適用

- モデル評価:MLflowと連携した評価プロセス

特にHuman-in-the-loop(人間が介在するフィードバックループ)の組み込みが重要な特徴となっています。

Human-in-the-loopとは、AIシステムの出力に対して人間が評価やフィードバックを行い、そのフィードバックをモデルの改善に活用するプロセスを指します。例えば:

- モデルの出力内容の品質評価

- 不適切な出力のフラグ付け

- プロンプトの改善提案

- 追加学習データの提供

このフィードバックループにより、モデルの品質と信頼性を継続的に向上させることができます。

まとめ

生成AIモデルの本番環境への展開は、従来のMLOpsの知見を活かしつつも、新しい課題に対応する必要があります。AWSは実証済みのワークフローとツールセットを提供することで、この課題に対応しようとしています。

特にプロンプト管理やヒューマンフィードバックの組み込みなど、GenAI特有の課題に対するソリューションは実用的です。従来のMLOpsの知見を活かしながら、新しい課題にも対応できる設計になっているのは、実際の開発現場でも使いやすい構成といえるでしょう。

セッション全体を通して実際のJupyter notebookを使ったデモが多く、各機能の使い方が具体的に理解できました。特にMLflowとの統合やパイプラインの構築など、実践的な内容が中心だったため、すぐに自分たちの環境でも試せそうな印象を受けました。

MLOps、FMOps、GenOpsという3つの概念を整理した上で、それぞれの課題に対するソリューションが提示されました。これらを活用することで、より信頼性の高い生成AIシステムの構築が可能になるでしょう。